La revolución Computex 2025 de NVIDIA: Transformar los centros de datos en fábricas de IA

Jensen Huang, CEO de NVIDIA, subió al escenario de Computex 2025 con su característica chaqueta de cuero y presentó nuevo hardware y un paradigma informático totalmente renovado. El gigante de los semiconductores se ha transformado de forma decisiva en una empresa de infraestructuras de IA, construyendo los cimientos de lo que Huang denomina "la infraestructura de la inteligencia", la tercera gran revolución de las infraestructuras tras la electricidad e Internet.

Esta keynote no fue un simple anuncio de productos, sino que Jensen expuso el plan de NVIDIA para remodelar el panorama informático. Los avances técnicos, los pivotes estratégicos y las estrategias de mercado que desveló harán de este Computex una referencia durante años. Ver el vídeo completo Computex 2025 de Nvidia.

Evolución estratégica de NVIDIA: De tarjetas gráficas a proveedor de infraestructuras

La historia de transformación de NVIDIA es alucinante. En 1993, Jensen vio una "oportunidad de 300 millones de dólares en chips", un mercado considerable. En la actualidad, está al mando de un gigante de infraestructuras de IA valorado en un billón de dólares. Este tipo de crecimiento explosivo no se produce de la noche a la mañana:VIDIA se ha reinventado a sí misma en múltiples ocasiones.

Durante su discurso, Jensen destacó los puntos de inflexión que han hecho posible la actual NVIDIA:

2006: CUDA aterrizó y puso patas arriba el cálculo paralelo. De repente, desarrolladores que nunca se habían planteado utilizar las GPU para el cálculo general empezaron a crear aplicaciones que habrían sido imposibles en las CPU tradicionales.

2016: El DGX1 se convirtió en el primer sistema de NVIDIA centrado en la IA sin compromisos. En lo que ahora parece una especie de presagio, Jensen donó la primera unidad a OpenAI, proporcionándoles la base computacional que acabaría conduciendo a nuestra actual revolución de la IA.

2019: La adquisición de Mellanox, que permitirá a NVIDIA reconceptualizar los centros de datos como unidades de computación unificadas.

Esta transformación culmina en la posición actual de NVIDIA como "empresa de infraestructuras esencial", un estatus que Huang enfatizó destacando sus hojas de ruta públicas sin precedentes a cinco años, que permiten planificar la infraestructura global para el despliegue de la IA.

Redefinición de las métricas de rendimiento: La economía de fichas

NVIDIA ha introducido un cambio fundamental en la forma de medir el rendimiento computacional. En lugar de métricas tradicionales como FLOPs u operaciones por segundo, Huang situó los centros de datos de IA como fábricas que producen "tokens", unidades de inteligencia computacional:

"Las empresas empiezan a hablar de cuántos tokens produjeron el trimestre pasado y cuántos tokens produjeron el mes pasado. Muy pronto, hablaremos de cuántos tokens producimos cada hora, como hacen todas las fábricas."

Este replanteamiento conecta directamente la inversión computacional y el rendimiento empresarial, alineando la infraestructura de IA con los marcos industriales tradicionales. El modelo sitúa a NVIDIA en el epicentro de un nuevo paradigma económico en el que la eficiencia computacional se traduce directamente en capacidad empresarial.

Actualizaciones de Blackwell Architecture: GB300 Especificaciones y métricas de rendimiento

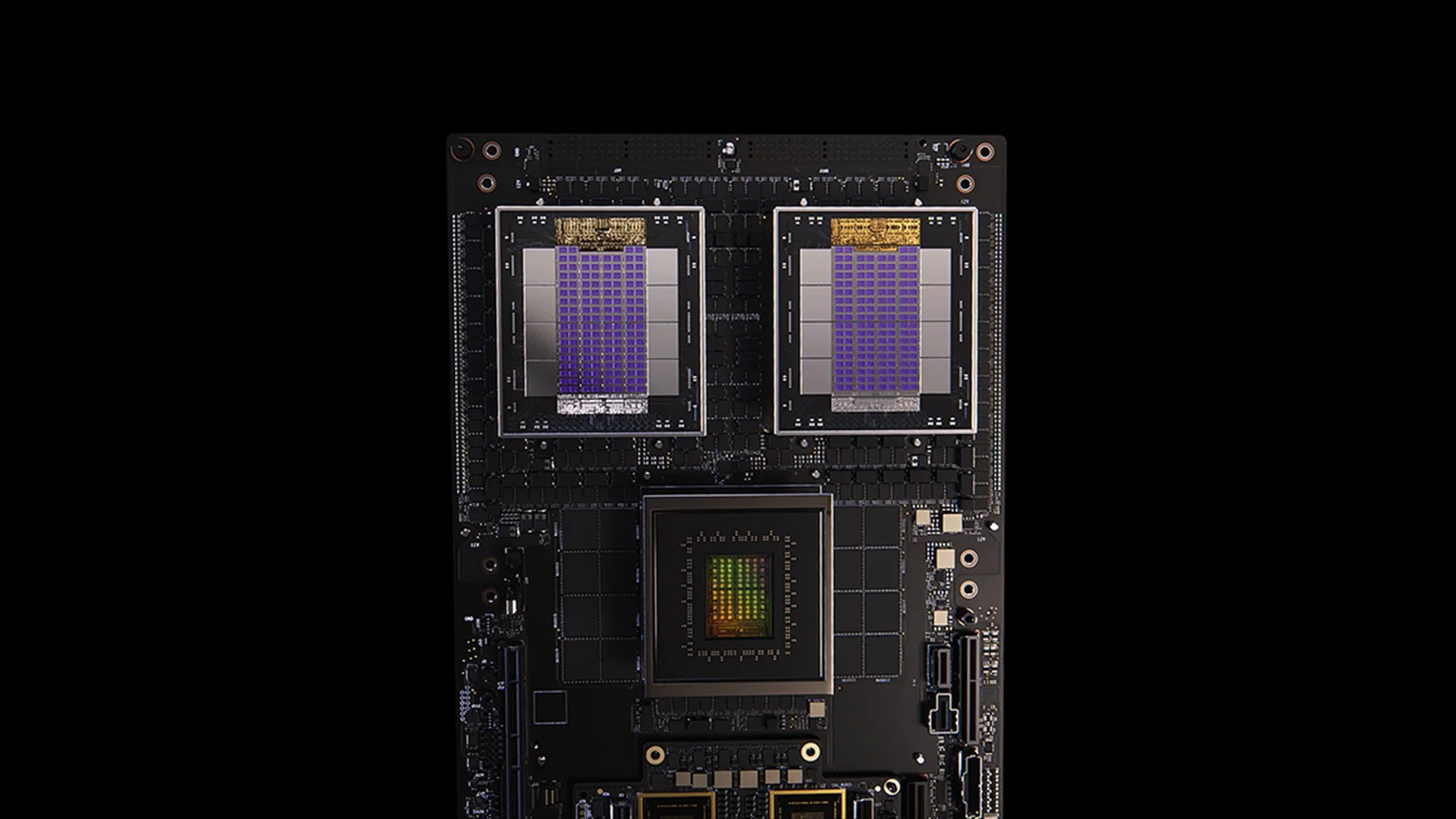

Sistema GB200

La actualización GB300 de la arquitectura Blackwell ejemplifica el incesante ciclo de mejora del rendimiento de NVIDIA. Prevista para el tercer trimestre de 2025, la GB300 ofrece:

1,5 veces más rendimiento de inferencia que GB200

1,5 veces más capacidad de memoria HBM

2 veces más ancho de banda de red

Diseño totalmente refrigerado por líquido

Compatible con los chasis y sistemas existentes

Cada nodo GB300 proporciona aproximadamente 40 petaflops, sustituyendo así a todo el superordenador Sierra (circa 2018), que requería 18.000 GPU Volta. Esta multiplicación por 4.000 del rendimiento en seis años supera con creces la escala tradicional de la Ley de Moore, lo que demuestra el enfoque polifacético de NVIDIA para acelerar el rendimiento a través de innovaciones en arquitectura, software e interconexión.

MVLink: Redefiniendo la tecnología de interconexión

MVLink representa el avance más significativo en la tecnología de interconexión de GPU desde la introducción de NVLink. El sistema permite la desagregación completa de los recursos de cálculo en todo un rack, convirtiendo 72 GPU (144 GPU dies) en una única unidad de cálculo masiva.

Las especificaciones técnicas son asombrosas:

Conmutadores MVLink individuales: 7,2 TB/s de ancho de banda

Lomo MVLink: 130 TB/s de ancho de banda total

Implementación física: 5.000 cables coaxiales de longitud exactamente igualada (aproximadamente 3 km en total).

Densidad de potencia: 120 kilovatios por bastidor (requiere refrigeración líquida)

Para contextualizar, Huang señaló que el pico de tráfico de toda Internet es de aproximadamente 900 terabits por segundo (112,5 TB/s), lo que hace que una sola columna MVLink sea capaz de gestionar más tráfico que la Internet mundial en su capacidad máxima.

Fusión MVLink: Creación de un ecosistema abierto de infraestructura de IA

MVLink Fusion podría ser la jugada más innovadora que NVIDIA ha realizado en años en el ecosistema. En lugar de obligar a sus socios a apostar por el hardware de NVIDIA, están abriendo la arquitectura para permitir a las empresas crear sistemas de IA semipersonalizados que sigan vinculados al universo NVIDIA.

El planteamiento es sorprendentemente flexible:

Integración de ASIC personalizados: ¿Tiene su acelerador especializado? No hay problema. Los partners pueden utilizar los chiplets MVLink para conectar su silicio personalizado al ecosistema de NVIDIA. Es como si NVIDIA dijera: "Construye el hardware especializado que quieras, pero asegúrate de que pueda comunicarse con el nuestro".

Integración de CPU personalizadas: Los fabricantes de CPU tampoco se quedan al margen. Pueden implementar directamente las interfaces chip a chip de MVLink, creando una autopista directa entre sus procesadores y las GPU Blackwell (o la futura arquitectura Ruben). MVLink es muy importante para las empresas que invierten en arquitecturas de CPU específicas.

Los anuncios de socios abarcan toda la industria de semiconductores:

Socios de implantación de silicio: LCHIP, Astera Labs, Marll, MediaTek

Vendedores de CPU: Fujitsu, Qualcomm

Proveedores de EDA: Cadence, Sinopsis

Este enfoque sitúa a NVIDIA en una posición estratégica para captar valor con independencia de la combinación de hardware específica que implanten los clientes, lo que refleja la sincera afirmación de Huang: "Nada me da más alegría que cuando compráis todo de NVIDIA. Quiero que lo sepáis. Pero me da una alegría tremenda que compres algo de NVIDIA".

Despliegue de IA en empresas: RTX Pro Enterprise y Omniverse Server

RTX Pro Enterprise y el servidor Omniverse representan la oferta de computación empresarial más importante de NVIDIA, diseñada específicamente para integrar las capacidades de IA en entornos de TI tradicionales:

Arquitectura totalmente compatible con x86

Compatibilidad con hipervisores tradicionales (VMware, Red Hat, Nanix)

Integración de Kubernetes para la orquestación familiar de cargas de trabajo

GPU Blackwell RTX Pro 6000s (8 por servidor)

Chip de red CX8 que proporciona un ancho de banda de 800 Gb/s

1,7 veces más rendimiento que la tolva H100

4 veces más rendimiento en modelos optimizados como Deepseek R1

El sistema establece un nuevo nivel de rendimiento para la inferencia de IA, medido en un marco de doble eje de rendimiento (tokens por segundo) y capacidad de respuesta (tokens por segundo por usuario), métricas críticas para lo que Huang describe como la era del "escalado del tiempo de inferencia" o "IA pensante".

Plataforma de datos de IA: Reimaginar el almacenamiento de datos no estructurados

AI Data Platform de NVIDIA introduce un enfoque fundamentalmente diferente del almacenamiento empresarial:

"Los humanos consultan bases de datos estructuradas como SQL... Pero la IA quiere consultar datos no estructurados. Quieren semántica. Quieren significado. Así que tenemos que crear un nuevo tipo de plataforma de almacenamiento".

Los componentes clave incluyen:

NVIDIA AIQ (o IQ): Una capa de consulta semántica

Los nodos de almacenamiento acelerados por GPU sustituyen a las arquitecturas tradicionales centradas en la CPU

Modelos de IA post-entrenados con procedencia transparente de los datos de entrenamiento

Consultas 15 veces más rápidas con un 50% más de resultados que las soluciones existentes.

Entre los socios del sector de almacenamiento que implementan esta arquitectura se encuentran Dell, Hitachi, IBM, NetApp y Vast, creando un ecosistema de gestión de datos de IA empresarial completo.

Operaciones de IA y robótica: Marcos de software para la empresa inteligente

En la ponencia se presentaron dos marcos de software cruciales:

Operaciones de IA (AIOps): Una pila completa para la gestión de agentes de IA en contextos empresariales, que incluye la curación de datos, el ajuste de modelos, la evaluación, los guardrails y la seguridad. Entre sus socios se encuentran Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat y Trend Micro.

Plataforma Isaac Groot N1.5: Un ecosistema de desarrollo robótico de código abierto que incluye:

Motor de física Newton (desarrollado con Google DeepMind y Disney Research)

Procesador robótico Jetson Thor

Sistema operativo NVIDIA Isaac

Plano de Groot Dreams para la generación de datos sintéticos de trayectorias

La iniciativa de robótica aborda un reto crítico: "Para que haya robótica, se necesita IA. Pero para enseñar la IA, se necesita IA". Este patrón de optimización recursiva aprovecha la IA generativa para ampliar los limitados datos de demostración humana y convertirlos en completos conjuntos de entrenamiento robótico.

Posición estratégica de Taiwán en la revolución de la fabricación con IA

Una parte importante del discurso destacó el papel fundamental de Taiwán en la producción y aplicación de tecnologías de IA:

Las empresas de fabricación taiwanesas (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) están utilizando NVIDIA Omniverse para la implementación de gemelos digitales.

TSMC utiliza herramientas de inteligencia artificial basadas en CUDA para optimizar la disposición de las fábricas y los sistemas de tuberías.

Los socios fabricantes utilizan gemelos digitales para la planificación virtual y el mantenimiento predictivo y como "gimnasios robóticos" para entrenar sistemas robotizados.

Foxconn, TSMC, el gobierno taiwanés y NVIDIA están construyendo el primer superordenador de IA a gran escala de Taiwán.

Huang reafirmó aún más el compromiso de NVIDIA con la región al anunciar los planes de "NVIDIA Constellation", una nueva sede en Taipei.

Análisis técnico: Qué significa esto para la estrategia de IA empresarial

En conjunto, estos anuncios representan una completa reimaginación de la informática empresarial con varias implicaciones estratégicas:

Requisitos de escala computacional: Las exigencias de rendimiento en tiempo de inferencia de la "IA razonadora" y los sistemas agenéticos generarán requisitos de computación significativamente mayores que los despliegues iniciales de modelos lingüísticos de gran tamaño, lo que requerirá una planificación arquitectónica para capacidades masivas de ampliación y reducción.

Desagregación de la IA empresarial: el ecosistema MVLink Fusion permite una flexibilidad sin precedentes en la creación de sistemas de IA heterogéneos, lo que podría acelerar la adopción de aceleradores de IA especializados al tiempo que mantiene la posición de NVIDIA en el ecosistema a través de la tecnología de interconexión.

Pasar de los centros de datos a las fábricas de IA: Tenemos que replantearnos por completo cómo medimos el valor de nuestras inversiones en infraestructura. Atrás quedaron los días en los que la capacidad bruta de computación o almacenamiento contaba toda la historia. Ahora todo gira en torno a la producción de tokens: ¿cuántas unidades de producción de IA pueden generar sus sistemas por segundo, por vatio y por dólar? Jensen no bromeaba cuando dijo que las empresas pronto informarían de su producción de tokens, como las métricas de fabricación. El cambio a las fábricas de IA reescribirá fundamentalmente la economía de cómo desplegamos y justificamos el gasto en infraestructura de IA.

Integración de gemelos digitales: El hecho de que todos los grandes fabricantes taiwaneses estén construyendo gemelos digitales Omniverse nos dice todo lo que necesitamos saber: ya no se trata solo de una demostración tecnológica genial. Los gemelos digitales se han convertido en una infraestructura esencial para las empresas que se toman en serio la optimización. Lo que es especialmente fascinante es cómo esto crea un bucle de retroalimentación: las empresas construyen gemelos digitales para optimizar los procesos físicos y, a continuación, utilizan esos mismos entornos para entrenar la IA y la robótica, mejorando aún más el mundo físico. Es un ciclo de mejora continua que no deja de acelerarse.

Planificación robótica del personal: La convergencia de la IA agéntica y la robótica física sugiere que las organizaciones deben desarrollar estrategias integradas de automatización digital y física, con implicaciones significativas para la planificación de la fuerza de trabajo y el diseño de las instalaciones.

Infraestructura definida por software: A pesar de los anuncios de hardware, el énfasis continuado de NVIDIA en las bibliotecas y marcos de software refuerza que la ventaja competitiva en IA vendrá de la optimización del software tanto como de las capacidades de hardware en bruto.

Navegar por la transición de la fábrica de IA

Transformar los centros de datos tradicionales en fábricas de IA requiere conocimientos especializados que tiendan un puente entre el despliegue de hardware, la optimización de software y el diseño arquitectónico. En Introl, hemos estado implementando estas avanzadas soluciones de infraestructura de GPU para empresas que dan el salto a la computación basada en IA. La amplia experiencia de nuestro equipo con el ecosistema de NVIDIA -desde complejas implantaciones de MVLink hasta implementaciones de gemelos digitales Omniverse- ayuda a las organizaciones a navegar por este cambio de paradigma sin la pronunciada curva de aprendizaje que suele asociarse a las infraestructuras de vanguardia. Tanto si está ampliando las capacidades de razonamiento de IA como si está construyendo su primera planta de producción de IA, asociarse con especialistas puede acelerar drásticamente la obtención de valor en este panorama en rápida evolución. ¿Listo para conseguirlo? Concierte una llamada hoy mismo.

Conclusión: Ha llegado la tercera era de la informática

En Computex, NVIDIA no se limitó a presentar chips más rápidos. Lo que Jensen presentó fue mucho más que los habituales anuncios de "un 20% mejor que el año pasado" a los que nos hemos acostumbrado. Está replanteando radicalmente la función de los ordenadores. Llevamos décadas construyendo máquinas que procesan números y mueven datos. Ahora, NVIDIA está construyendo sistemas que fabrican inteligencia como resultado principal. Es como comparar un archivador con un cerebro. Ambos almacenan información, pero uno se queda ahí mientras el otro crea nuevas ideas. El cambio puede parecer semántico hasta que te das cuenta de que lo cambia todo en cuanto a la forma en que construimos, implantamos y medimos los sistemas informáticos.

"Por primera vez en todo el tiempo que llevamos juntos, no solo estamos creando la próxima generación de TI, sino que además lo hemos hecho varias veces, del PC a Internet, a la nube y a la nube móvil. Lo hemos hecho varias veces. Pero esta vez, no sólo estamos creando la próxima generación de TI, estamos creando toda una nueva industria".

Esta transición representa el tercer gran cambio de paradigma informático, tras la revolución de la informática personal y la era de Internet y la nube. Es probable que las organizaciones que integren estas capacidades de infraestructura de IA establezcan ventajas competitivas insuperables en todos los sectores.

Las fábricas de inteligencia computacional están en construcción hoy en día. La cuestión ya no es si la IA transformará los negocios, sino si su organización está construyendo la infraestructura necesaria para seguir siendo competitiva en un mundo en el que la inteligencia computacional se convierte en algo tan fundamental para las operaciones empresariales como la electricidad.

Referencias y recursos adicionales

Visión general de la arquitectura Blackwell oficial de NVIDIA: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

Documentación técnica de NVIDIA MVLink: https://developer.nvidia.com/mvlink

Plataforma NVIDIA Omniverse: https://www.nvidia.com/en-us/omniverse/

Plataforma Robótica Isaac: https://developer.nvidia.com/isaac-ros

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

Material de prensa oficial de NVIDIA Computex 2025: https://nvidianews.nvidia.com/news/computex-2025

Visión general de las librerías NVIDIA CUDA-X: https://developer.nvidia.com/gpu-accelerated-libraries

Sistemas NVIDIA DGX: https://www.nvidia.com/en-us/data-center/dgx-systems/